Last updated: 2026-01-21

2026년, 생성형 AI는 필수 도구이지만 할루시네이션(환각), 맥락 유실 등 오류가 빈번합니다. 이 글은 AI 오류의 원인을 분석하고, RAG 기술 활용 및 교차 검증과 같은 명확한 해결책을 제시합니다. 또한, 오류를 원천 차단하는 효과적인 프롬프트 작성법과 개인정보 보호, 저작권 문제 등 반드시 지켜야 할 AI 사용 시 주의사항을 총정리하여 AI를 안전하고 현명하게 활용하는 완벽 가이드를 제공합니다.

목차

- 도입: 생성형 AI 시대, 오류 해결이 필수인 이유

- 가장 흔한 생성형 AI 오류 유형 5가지와 원인 분석

- 치명적 오류 ‘할루시네이션’ 완벽 해부 및 해결 전략

- 오류를 원천 차단하는 프롬프트 작성의 기술

- AI 사용 시 반드시 지켜야 할 주의사항 7가지

- 2026년, AI와 함께 성장하기 위한 준비

- 결론: 현명한 AI 활용을 위한 최종 체크리스트

- 자주 묻는 질문 (FAQ)

- References

1. 도입: 생성형 AI 시대, 오류 해결이 필수인 이유

2026년, 업무와 일상의 필수 도구가 된 생성형 AI를 사용하며 예상치 못한 답변에 당황한 경험이 있다면, 가장 먼저 생성형 AI 오류 해결법을 익혀야 할 때입니다. ChatGPT, Claude, Gemini와 같은 서비스가 보편화되면서 사용자 수는 폭발적으로 증가했지만, 그만큼 AI가 만들어내는 오류를 경험하는 빈도 또한 급격히 높아졌습니다. AI의 답변을 무심코 믿었다가 곤란한 상황에 처하는 것은 더 이상 남의 이야기가 아닙니다.

실제로 최근 Google AI가 “피자에 접착제를 바르라”고 답변한 사례는 큰 충격을 주었습니다. 이는 AI가 온라인상의 농담 섞인 게시물을 실제 정보로 오인하여 발생한 대표적인 ‘할루시네이션(환각)’ 현상으로, AI가 문맥을 완벽히 이해하지 못하고 잘못된 정보를 사실처럼 제공할 수 있다는 문제의 심각성을 보여줍니다. AI의 비약적인 발전에도 불구하고, 이러한 오류는 여전히 존재하며 사용자의 비판적인 시각을 요구합니다.

이 글은 단순한 문제 나열을 넘어, 여러분이 생성형 AI를 사용하며 겪을 수 있는 문제들을 스스로 진단하고 해결하는 능력을 갖추도록 돕는 완벽 가이드입니다. 이 글을 끝까지 읽으신다면, (1) 흔한 오류 유형과 명쾌한 원인을 파악하고, (2) 문제 발생 시 즉각적으로 적용할 수 있는 해결책을 습득하며, (3) 오류를 사전에 방지하는 효과적인 프롬프트 작성 기술을 익히고, (4) 안전한 AI 활용을 위한 필수 AI 사용 시 주의사항까지 완벽하게 숙지하게 될 것입니다.

2. 가장 흔한 생성형 AI 오류 유형 5가지와 명쾌한 원인 분석

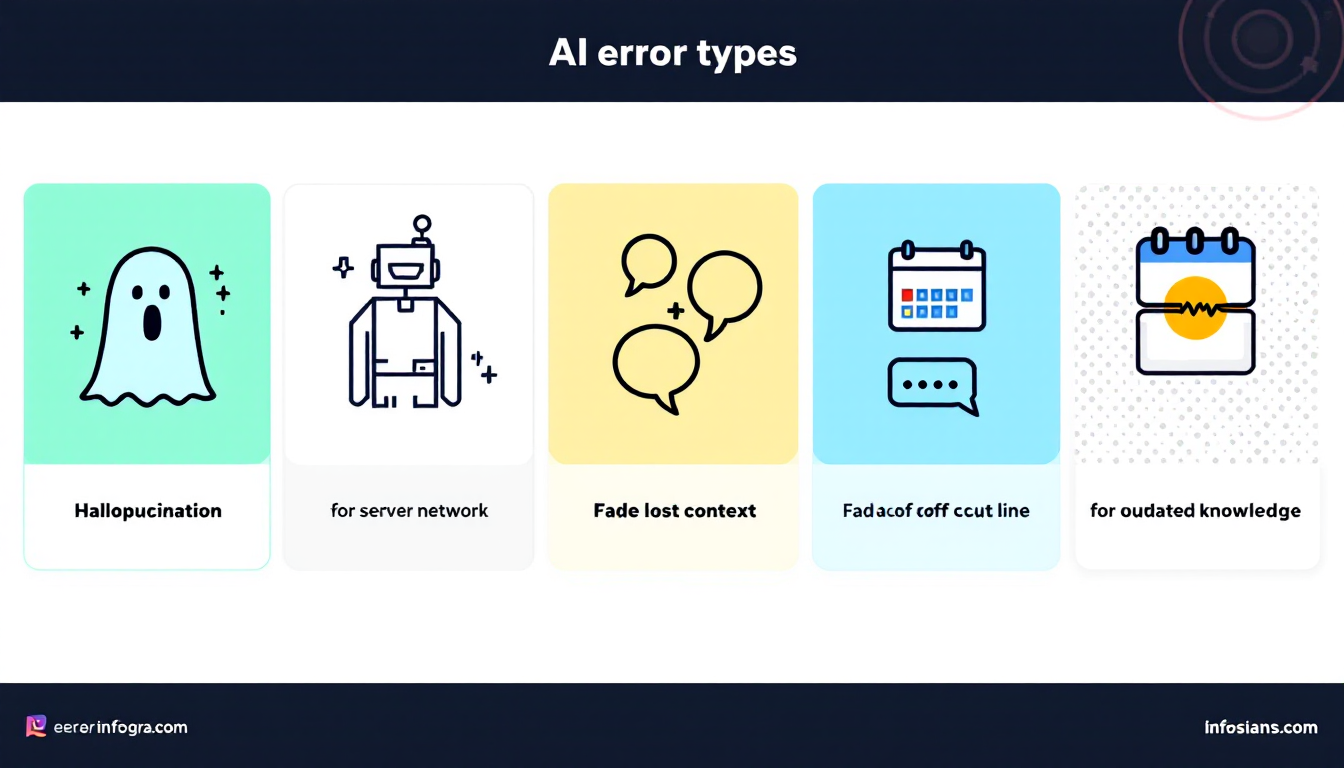

생성형 AI 사용 중 겪는 문제들은 대부분 몇 가지 유형으로 압축됩니다. 문제의 원인을 정확히 알아야 올바른 생성형 AI 오류 해결법을 찾을 수 있습니다. 사용자들이 가장 흔하게 마주치는 오류 유형 5가지는 다음과 같습니다.

- 할루시네이션 (Hallucination, 환각 현상)

가장 치명적이면서도 흔한 오류입니다. AI가 존재하지 않는 사실, 잘못된 정보, 왜곡된 데이터를 마치 진실인 것처럼 확신에 차서 생성하는 현상을 말합니다. 이는 AI 모델이 학습한 데이터 자체의 편향성이나 불완전성, 그리고 정답을 찾는 것이 아니라 통계적으로 가장 그럴듯한 단어를 예측하는 모델의 근본적인 작동 방식 때문에 발생합니다. - 응답 중단 및 서버 오류

Network Error 메시지와 함께 답변 생성이 중간에 멈추는 경우입니다. 이는 주로 특정 시간대에 사용자가 급증하여 서버에 과부하가 걸리거나, 서비스 제공자 측의 일시적인 기술 문제로 인해 발생합니다. 대부분의 경우 사용자 기기나 네트워크의 문제라기보다는 AI 서비스 자체의 이슈일 가능성이 높습니다. - 컨텍스트(맥락) 유실

AI와 긴 대화를 이어갈 때, 어느 순간부터 AI가 이전 대화 내용을 기억하지 못하고 주제와 관련 없는 답변을 하는 현상입니다. 이는 모든 AI 모델이 한 번에 기억할 수 있는 대화의 양, 즉 ‘컨텍스트 윈도우(Context Window)’ 또는 ‘토큰 제한’이 정해져 있기 때문입니다. 이 한도를 초과하면 AI는 오래된 대화부터 잊어버리기 시작하며, 이는 많은 초보자 실수 및 해결책이 필요한 대표적인 사례입니다. - 정보 최신성 부족 (Knowledge Cutoff)

이는 AI 모델이 특정 시점까지의 데이터로만 훈련되었기 때문에 그 이후에 발생한 사건이나 최신 정보를 알지 못하는 문제입니다. 실시간 검색 기능이 없는 모델에서 두드러지게 나타나는 한계입니다. - 언어적/문화적 오해

AI 모델은 주로 영어권 데이터를 기반으로 학습되는 경우가 많아, 한국어 특유의 미묘한 뉘앙스나 사회·문화적 배경을 완벽하게 이해하지 못할 때가 있습니다. 이로 인해 번역투의 어색한 문장을 생성하거나, 한국적인 맥락을 전혀 고려하지 않은 부적절한 답변을 내놓기도 합니다.

3. 치명적 오류 ‘할루시네이션’ 완벽 해부 및 해결 전략

할루시네이션은 생성형 AI의 신뢰도를 가장 크게 위협하는 문제입니다. 최신 모델들조차 이 문제에서 자유롭지 않습니다. 예를 들어, Vectara의 공개 리더보드(할루시네이션 평가)와 같은 벤치마크는 모델별 환각 성향이 “완전히 0”이 아님을 보여줍니다. 결국 핵심은 “환각이 존재한다”는 전제를 두고, 업무 프로세스에서 이를 통제하는 방법을 갖추는 것입니다.

이처럼 피할 수 없는 할루시네이션에 대응하기 위한 가장 효과적인 생성형 AI 오류 해결법 3가지를 소개합니다.

해결 전략 1: RAG (검색 증강 생성) 적극 활용

RAG(Retrieval-Augmented Generation)는 할루시네이션을 줄이는 가장 강력한 기술입니다. 이 기술은 AI가 내부 학습 데이터에만 의존해 답변을 생성하는 것이 아니라, 답변 생성 시점에 실시간으로 웹을 검색하거나 사용자가 업로드한 최신 문서를 참조하도록 합니다. 다만 전문 분야(예: 법률)에서는 RAG를 적용해도 오류가 남을 수 있다는 연구 결과도 있어, RAG = 무조건 정답으로 받아들이면 안 됩니다.

해결 전략 2: 교차 검증 (Cross-Checking) 습관화

중요한 정보일수록 최소 2개 이상의 모델로 동일 질문을 던져 비교하고, 마지막에는 원문 출처(공식 문서/논문/정부 사이트 등)를 직접 확인해야 합니다. 특히 숫자, 법령, 정책, 의료·재무·보안처럼 고위험 분야는 교차 검증이 사실상 필수입니다.

해결 전략 3: 근거 제시 요구 프롬프트 사용

AI가 더 신중하고 사실에 기반한 답변을 하도록 유도하는 방법입니다. 프롬프트에 다음 요구사항을 포함하면 환각을 “완전히 제거”하진 못해도, 실무에서 위험도를 크게 낮출 수 있습니다.

- “너의 답변에 대한 근거를 설명해 줘.”

- “신뢰할 수 있는 출처의 URL(또는 문서명/조항)을 함께 제시해 줘.”

- “추측해서 답변하지 말고, 모르면 ‘모른다’고 말해 줘.”

4. 오류를 원천 차단하는 프롬프트 작성의 기술

오류가 발생한 뒤에 해결하는 것도 중요하지만, 더 현명한 방법은 오류 발생 가능성 자체를 최소화하는 것입니다. 그 핵심은 바로 ‘프롬프트 작성 기술’에 있습니다. AI는 사용자가 지시한 만큼만 똑똑하게 작동하기에, 명확하고 구조화된 프롬프트는 초보자 실수 및 해결책의 가장 기본이 됩니다.

1. 명확하고 구체적인 지시

모호한 질문은 모호한 답변으로 이어집니다. 페르소나, 형식, 분량, 목적을 구체적으로 지정하세요.

- 나쁜 예 (X): “AI에 대해 알려줘.”

- 좋은 예 (O): “당신은 IT 전문 작가입니다. 초등학생도 이해할 수 있도록, 생성형 AI의 기본 원리를 비유로 설명하고, 대표 서비스 3가지(ChatGPT, Claude, Gemini)의 특징을 표로 정리해 주세요.”

2. 충분한 맥락(Context) 제공하기

AI가 배경지식 없이 추측하게 만들면 오류 확률이 올라갑니다. 질문에 필요한 핵심 배경 정보를 함께 제공하세요.

3. 단계별 사고 유도

복잡한 질문은 단계로 쪼개 순차 지시하는 방식이 안전합니다.

4. 부정 명령어 활용

특히 환각 억제에 효과적입니다. “추측 금지”, “근거 없는 내용 금지”를 명시하세요.

5. AI 사용 시 반드시 지켜야 할 주의사항 7가지

기술적 오류를 피하는 것만큼이나 중요한 것이 바로 AI를 안전하고 윤리적으로 사용하는 것입니다. 다음 7가지 AI 사용 시 주의사항은 AI를 활용하는 모든 사용자가 반드시 숙지하고 지켜야 할 최소한의 안전장치입니다.

- 개인정보 및 민감정보 입력 절대 금지

주민등록번호, 신용카드 번호, 계좌, 비밀번호, 회사 기밀/고객정보 등은 절대 입력하지 마세요. - 저작권 문제 항상 인지

AI 생성물의 상업적 이용은 저작권/상표권 분쟁 리스크가 있습니다. 특히 특정 작가 화풍/로고 모방은 피하세요. - AI 생성물 표시 의무/가이드 확인

2026년 1월 22일 시행되는 AI 기본법 및 관련 정책 흐름에 따라, 상업적 목적의 AI 생성물은 표시 의무/가이드라인이 강화될 수 있습니다. - 결과물 맹신 금지 (최종 책임은 사용자)

AI는 보조 도구입니다. 법적·윤리적 책임은 사용자에게 있습니다. - 편향(Bias) 인지

차별/편견이 섞인 결과물이 나올 수 있으니 비판적으로 검토하세요. - 유료/무료 플랜 차이 이해

중요 업무(보고서/분석)는 더 안정적인 환경을 고려하세요. - API 사용 시 비용 관리

토큰 비용 폭증을 막기 위해 모니터링/한도 설정이 필요합니다.

6. 2026년, AI와 함께 성장하기 위한 준비

2026년 이후 생성형 AI는 더 똑똑해지는 것뿐 아니라, 스스로 오류를 줄이고 사실성을 높이는 방향으로 진화할 것입니다. 하지만 기술 발전이 사용자의 역할을 대체하지는 않습니다. 오히려 AI의 성능이 고도화될수록 제대로 활용하는 역량이 더 중요해집니다.

세계경제포럼(WEF) 등 여러 전망은 공통적으로 AI 시대 핵심 역량을 강조합니다. 특히 다음 두 가지는 “AI가 강해질수록” 더 중요해집니다.

- 비판적 사고 및 팩트체킹 능력: 진짜/가짜를 구별하고 가치 있는 정보를 선별하는 능력

- 정확한 질문을 던지는 능력(프롬프트 엔지니어링): AI를 “잘 쓰는 사람”이 되기 위한 핵심 기술

7. 결론: 현명한 AI 활용을 위한 최종 체크리스트

오류는 피할 수 없는 현실이지만, 제대로 다루면 두려울 대상이 아닙니다. 아래 체크리스트를 습관처럼 점검해 보세요.

초보자를 위한 AI 활용 최종 체크리스트

- [ ] 원하는 결과물의 역할/형식/목적을 구체화했는가?

- [ ] 민감정보(개인/회사)를 입력하지 않았는가?

- [ ] 중요 정보는 교차 검증했는가?

- [ ] 출처를 요구하고 원문 확인까지 했는가?

- [ ] 저작권/표시 의무/윤리 리스크를 검토했는가?

자주 묻는 질문 (FAQ)

Q: 생성형 AI가 생성한 정보는 항상 정확하고 신뢰할 수 있나요?

A: 그렇지 않습니다. 환각(할루시네이션)으로 인해 존재하지 않는 사실을 만들 수 있습니다. 중요한 정보는 교차 검증과 원문 출처 확인이 필수입니다.

Q: AI와 대화할 때 개인정보나 회사 기밀을 입력해도 괜찮나요?

A: 절대로 안 됩니다. 개인정보/기밀은 보안 사고로 이어질 수 있으며, 서비스 정책에 따라 입력 데이터가 활용될 가능성도 있습니다.

Q: AI가 만들어준 글이나 이미지는 저작권 걱정 없이 사용해도 되나요?

A: 아닙니다. 학습 데이터의 영향으로 저작권 침해 소지가 생길 수 있습니다. 특히 상업적 이용은 더 조심해야 합니다.

References

- 법제처 국가법령정보센터, 「인공지능 발전과 신뢰 기반 조성 등에 관한 기본법」(시행 2026. 1. 22.) [링크]

- 공정거래위원회(FTC), AI 생성물 표시 의무 관련 보도자료(2025-12-09) [링크]

- Stanford HAI, “AI on Trial: Legal Models Hallucinate in 1 out of 6 (or More) Benchmarking Queries” (2024-05-23) [링크]

- Vectara, Hallucination Leaderboard (공개 리더보드/코드) [링크]

- World Economic Forum, “The Future of Jobs Report 2025” (2025-01-07) [링크]

- Google AI Overviews 관련 오류 사례(‘glue on pizza’) 보도 예시 [링크]

- 법제처 국가법령정보센터, 「개인정보 보호법」 [링크]

- 법제처 국가법령정보센터, 「저작권법」 [링크]